- ISO1600

- Manual mode

- f11

- 露出時間 30sec (雑な赤道儀運用で 300mm でも撮影した星が流れないという基準)

- 長秒時ノイズ低減 OFF

- 好感度ノイズ低減 OFF

- VR ON (VR 機能があるレンズは OFF にすることをおすすめ単に忘れただけ)

2023/12/15

M42 を撮ってみたい(その2)

2023/12/09

MAK127用フォーカサー Ver.4

MAK127に EAF などのフォーカサーを取り付けている猛者もいるようですが作るの好きなんで作ってみました。そもそも MAK127 は素直に電動フォーカサー付けるところ無いんだよなぁ。ぶつぶつ。

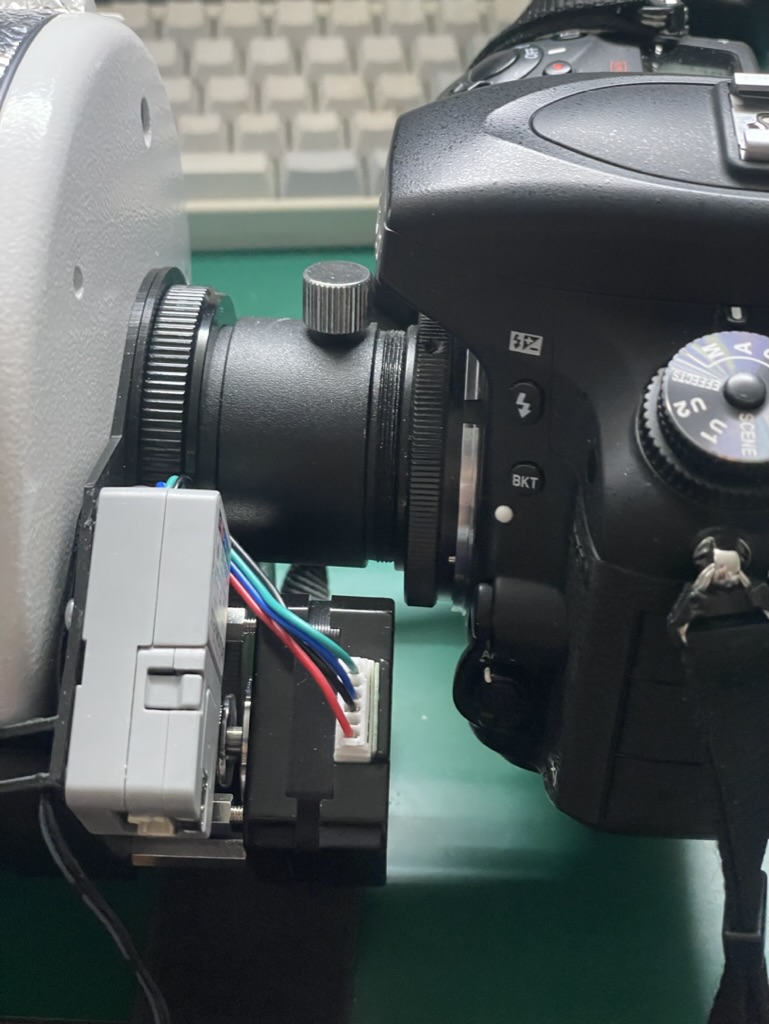

ところで我が MAK127用フォーカサーもついに Ver.4。ハード的には最終版。。だと思ってます。Ver.3 に比べ小型軽量化に成功です(当社比)!PC との接続はUSB-C ケーブルにて接続してください。

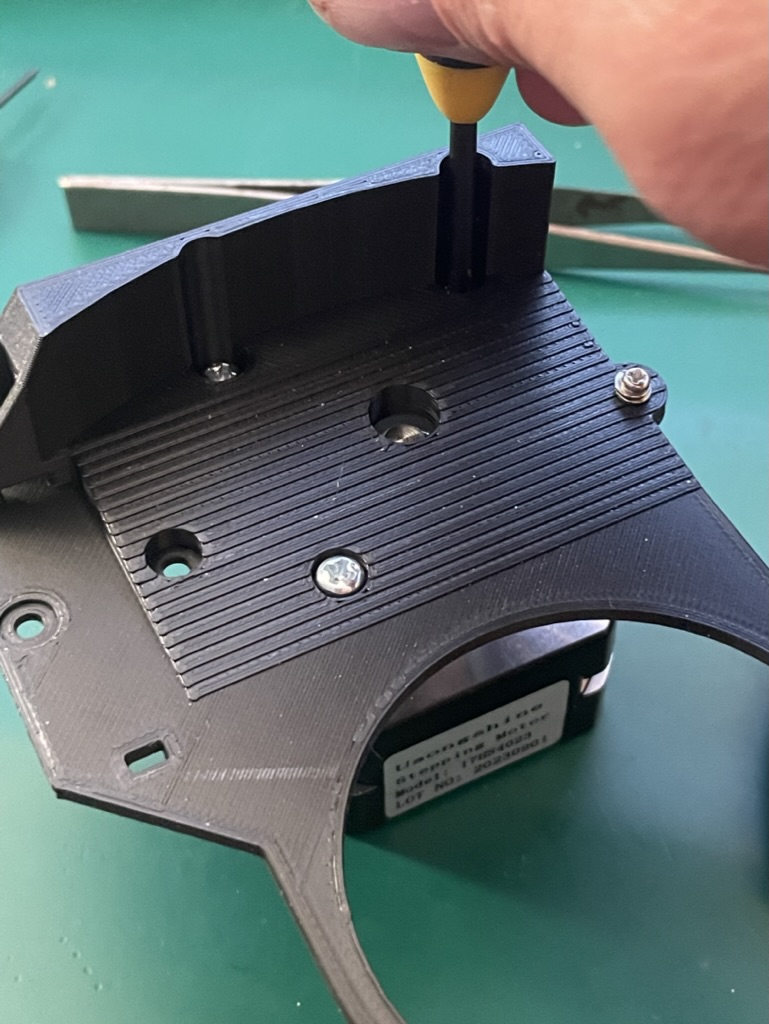

今回の Ver.4 はだいぶコンパクトに載ってるでしょ?(最終盤はこれより厚みがあるモーターに交換しました)。これまではアリガタにアリミゾクランプをつかってモータを取り付けてたのですが、今回は 3D プリンターでモータを載せる土台を作って接眼部にはめ込む作りにしました。

- バイポーラステッピングモーター SM-42BYG011 x1

- タイミングベルト6mm幅182mm周囲長 x1

- プーリー5mmボア6mm幅 x1

- プーリー12mmボア6mm幅 60T x1

- ATOM STEPMOTOR Kit x1

- 六角スペーサー 20mm x 3

- なべ小ネジ M3 5mm x5

- なべ小ネジ M3 35mm x1 (+ナット x1)

- DCジャック付きケーブル x1

- DC12V 電源 x1

組み立て

以上で組み立てはおしまいです。

ソフトウェア

ATOM STEPMOTOR Kit のファーム

ユーザーインターフェース

木星を撮る2023年度版 (自動導入とトラッキング)

みなさんどんな感じで天体導入しているのかわからないんですが、もっといい方法あったりしたら教えてください。と前置きしておきます。

これを書いてる時点で MAK127 と AZ-GTi のセットを買ってもう4年目(遠い目)。コロナ禍をきっかけに天文ほぼ素人から始めて、いまだにわからないこともいっぱいあるのですが、今年2023年は木星を撮影しまくり、ようやく撮影がルーチンワーク的に進められるようになってきました。そこに至る経緯と現状について MAK127+AZ-GTi での観点からメモしておきます。ちなみに今年の木星シーズン初めの頃はまだモタモタしてました。というのもそれまでは撮影するのが一苦労でワンシーズンでそれほど撮影してないんで色々向上しなかったと。

ところで撮影環境は東京都内西部(環七と環八の間らへん)の自宅です。自宅は北極星がギリギリ視認できる程度の光害レベル。従って MAK127 付属の x1 のドットファインダーのみではよほど明るい天体でないと導入できないへなちょこなので、自動導入という仕組みがなかったら望遠鏡買ってなかったなーと。望遠鏡は撮影ごとに出したりしまったりするので毎度毎度前事前準備が必要です(ベランダに置いた収納ボックスにカメラ以外の望遠鏡一式が入れっぱなしなのですぐ出せはしますが)。

また自宅は木造建築なので、望遠鏡を出してるベランダが揺れやすいだけでなく(家族が家の中でドタドタしても揺れる。。)、立っている位置を変えると導入している天体が簡単にズレます。高倍率の時は最悪です。

過去の経緯1

MAK127+AZ-GTi を初めて買った年は右も左もわからずググって接眼レンズを通してカメラ撮影できるらしいということを知り、MAK127 に付属の接眼レンズを拡大撮影用アクセサリー を通し、D750 を接続して撮影に挑んでました。ファインダーは MAK127 に付属のドットファインダーのみです(後で色々変える)。手順は以下でした。ちょっと思い出しながらなので正確じゃないところもあるかも。基本的にはファインダーを調整しておく。天体を導入したらとにかくファインダーを再調整しておく。途中すっ飛んでも大丈夫なようにとにかくファインダーはこまめに調整しておく。で、今でも流れは変わってないです。

天体の導入

- 20mm のアイピースでファインダーの調整

適当な地上の目標を使い、20mm のアイピースで目標を導入(カメラなし。眼視で)します。AZ-GTi に SynScan App で接続し、方向キーで目標を正確に視界の中央にします。ドットファインダーを目標に合わせます。ここも極力正確に。 - 10mm のアイピースでファインダーの調整

更にアイピースに変えてさらに追い込む。ピントが合う位置がズレるのでピント調整しなおし。 - アライメント

ファインダーの調整が終わったらAZ-GTi のアライメントを行います(1~2スター。状況に応じて。3スターまではやってないです。対象の天体が見えなかったりわからないケースが多いので)。まずは AZ-GTi の水準器を見て水平に。そして経緯台モードなら望遠鏡も水平(スマホの水準器とか使うと便利)、スマホのアプリなど使って北の方向に向けておきます。スマホのアプリって毎回微妙に方向変わったりと正確に合わせるの難しいです。もうざっくり。ちなみに自宅から北極星は見えるので、だいたいこっちかなーと微調整するときもあります。ここで忘れないようにするのが、AZ-GTi の高度と方位クラッチのネジをきっちり締め直すこと!たまにネジが甘くてトラッキング時にあれあれ?となったりします。あとファインダーを触らない!ちょんと触ってズレて後で使えなくなることもしばしば。ちなみに付属のドットファインダーの調整ネジや本体は遊びが多いのでテープでぐるぐる巻きにしてみたりと少し工夫してます。

ようやくここでアライメントを開始するボタンをクリック。アライメント先の天体がだいぶ離れたところに導入されてたりします(いつも思うんですがこんなもんなんですかねぇ。。それなりに水平と北向きは合わせてるつもりなんですが。自分のいる位置によってベランダが歪むのも一因だとは思うんですが)。流石に x1 のドットファインダーの視野には入っているので、覗きながら赤ポチを天体が中央になるように AZ-GTi の方向制御ボタンをポチポチしながら導入します。続いてアイピースを覗き、天体がセンターになるように調整してようやくアライメント終了。念の為、最後に合わせた天体でファインダーを再調整しておきます。 - 自動導入

ようやく目的の天体を導入。導入直後はほぼほぼズレているので、ファインダーを覗きながら赤ポチに天体が入るよう AZ-GTi の方向ボタンをポチポチします。これでアイピースを覗いた時に天体が真ん中に導入されていればラッキー。見つからなかったら AZ-GTi を操作しながら周囲を探しに行きます。ファインダーの赤ポチで天体の周辺をぐるぐる探す感じです。見つかったらアイピースで覗いてセンターに移動、ファインダーも再調整です。ファインダーの調整は結構荒いので、赤ポチと星をちょうど重ねるのは難しいかもしれませんので、赤ポチのやや左側とかそんな感じでセンターになった場合どこら辺に合わせて置いたか記憶しておきます。ちなみにファインダー覗いて位置合わせを追い込むので暗い天体は厳しいです。うちの場合、土星でやや厳しい。 - カメラ装着

鬼門です。アイピースを外して拡大撮影用アクセサリーに差し込んで、D750 と接続したものを差し替えます。カメラが結構重いのでせっかく天体を導入していてもすっ飛びます。経緯台の場合主に高度方向にズレるだけなので上下させるだけですぐ導入できる場合がありますが、ファインダー覗いて赤ポチを頼りにズレを戻すと導入しやすいです。カメラの感度もガンガンに上げておくと漏れ出てくる光でなんとなくそっちに天体があるかもというのがわかる時があるので、それを頼りに導入を行います。それでも導入が厳しい場合は 10mm -> 20mm のアイピースに戻して広い範囲からセンターに順に追い込みます。ただこの場合ピントのずれが大きくてピントを再調整する必要があったりするので、ピント調整で望遠鏡がグラグラするので辛いです。今思えばファインダーの調整、アライメントの段階からカメラ装着して位置を追い込んでも良かったなと思います。最近はいきなり高倍率状態でアライメントしちゃいます。

トラッキング

SynScan App での方向キーでの架台のコントロールは PC のゲーム用コントローラーで行うことができます。少なくとも PC の SynScan Pro App 最新版では。PC の画面をマウスでクリックしたり、携帯の SynScan App を指で制御するより明確でわかりやすです。もしゲーム用コントローラをお持ちでしたら試してください。Windows だと有線でも無線でもどちらでもOKでした。

過去の経緯2

天体の導入

過去の経緯3

天体の導入

2023年度

天体の導入

ファインダーの改善

- 無理な姿勢でファインダーを覗く必要がなくなった

- 焦点距離を短めにして広範囲を表示してアライメントに迷うことない状態にし、導入で追い込む時は電子的に拡大してとファインダーの焦点距離を擬似的に複数持つことができてファインダーを一つに集約できた

- ファインダーは PC で確認できるようになったので、別な PC からログインするというリモート活用ができるようになった

右が SharpCap の Ceres-C (電子ファインダー) x800 の最大倍率での合わせ込み中

電視ファインダーをこんな感じで合わせ込みをしてます。表示したクロスゲージのど真ん中になるよう電視ファインダーのネジを調整しておきます。

トラッキング

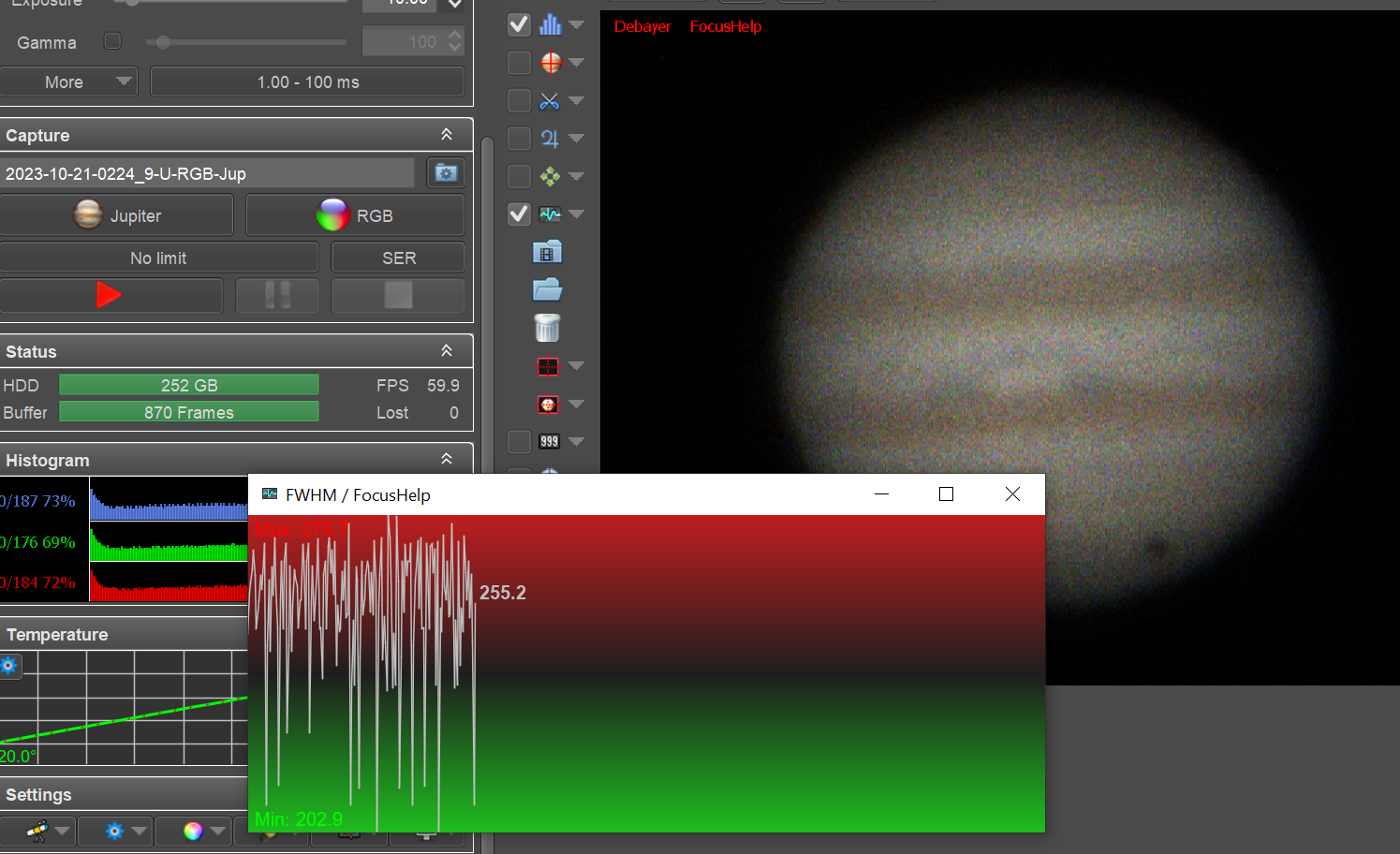

2023/10/21

FireCapture のプラグイン (フォーカス関連)

FireCapture を使い始めて間もないのですが、少しずつ使えるようになってきて、プラグインに興味が出てきました。というのもピント合わせに使えそうな FocusHelp 機能があるのですが、表示しても挙動がなんだかよくわからず。。

で、調べてみると

http://www.firecapture.de/ReleaseNotes.pdf

に FWHM ベースの演算に置き換えたよと書かれてます。

FWHM って何?かというと、

https://sharpcap-jp.sakura.ne.jp/SharpCapUserManual_JP-web/18_.htm

点光源で星の幅を測るということらしいです。確かにピントが合ってないと光源が大きく見えたりするので、それを利用するのもありなのかなと思いますが、惑星向きとは書いてませんね。でもたしか FocusHelp にリセットとかあったけど、それで初期化してみたことはないな。。なんかリセットすると使えたりするのかな。。

ということで、ほかの手段を探してみました。

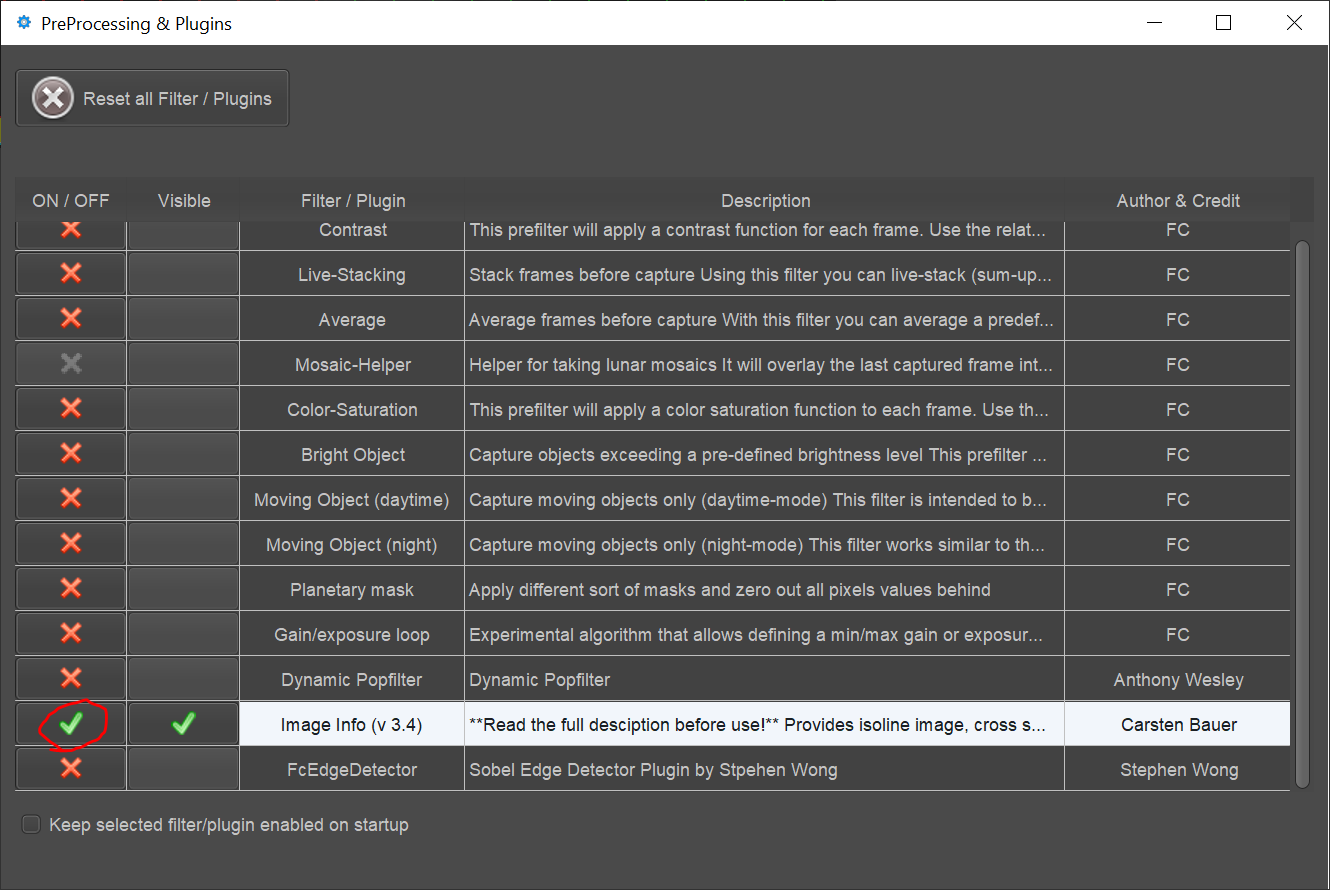

FireCapture のサイトの下の方にプラグインっていうのがあります。Description を眺めてみると、EdgeDetection と ImageInfo という二つのプラグインが惑星のフォーカスというキーワードがあるので使えそうです。

インストール

う。。わからない。Java でのプラグインの作り方の動画はあるんですが。仕方ないのでそれを見ると、FireCapture のインストールしたパスの下の pulgins の下の x64 の下に置けばよさそうです。FireCapture のサイトから(ほかのサイトに誘導されるものもある)ダウンロードしたプラグインを展開して、そのフォルダをここに置きます。 それぞれのプラグインフォルダの下にプラグイン .jar が置かれてる感じですね。うちではこんな感じになります。

使い方

PreProcessing の None をクリックします。

すると次のウインドウが立ち上がるので、有効にしたいプラグインの ON/OFF の×をクリックすると有効になります。

左下の Keep selected filter/plugin enable on startup にチェックを入れておくと次回起動時に ON したフィルタかプラグインが自動的に有効になります。

Image Info

ついでにオプションのボタンも押してオプションを表示してみました。なにやらいろいろ設定項目があります。詳細はプラグインについてるドキュメントを読んでください。5 Usage hints が参考になるか。。な。フォーカスが合い始める点と再び悪くなる点に着目するとか、ゲイン高めで中央がやや露出オーバーになった方が合わせやすくていいかもとか。

EdgeDetec

2023/09/08

ATOM SPP を作ってみた (Bluetooth SPP を使った WiFi とは違う AZ-GTi の無線化)

はじめに

だいぶ前に SynScan USB を作ってみた。という記事を書きましたが、今度はその無線版です。

作ってみたものの、なんか通信エラー出るなと思ってたんですが、ファームを変更し、Windows のシリアルの設定を変更したらまぁまぁ安定するようになってきた気がします。でもまだまだ感は否めず。

AZ-GTi はもともと WiFi (無線)で接続できるのに何それ?と思うかもしれませんが、AZ-GTi に WiFi 接続する方法は二つあって、AZ-GTi を WiFi のサーバーとして携帯もしくは PC を接続する方法と、AZ-GTi を既存の WiFi ネットワークにぶら下げて、携帯もしくは PC からそのネットワーク経由で AZ-GTi に接続する方法の二通りがあります。

前者だと AZ-GTi がサーバーになってしまうので接続した携帯または PC は外部ネットワークに接続することができなくなってしまいます。後者だと WiFi ネットワークの電波が AZ-GTi を動かしたい場所まで飛んでいないと使えないという不便さがあります。

したがってその不便さを解消するために今までは AZ-GTi を接続するのに SynScan USB (もどき) でシリアル+USB ケーブルにて接続していました。ケーブル接続の方が無線より確実!かもしれないのですが、アライメントをとってる最中とか、導入先を変えるときに PC を持って移動するとケーブルひっかけて接続が切れる。。ことがたまにありました。なので大量のデータを流すカメラはともかくコントローラ程度に対して有線にこだわりは全くなくて。

ちなみに架台さえ対応していれば SynScan Pro で BLE でも接続できるようですが、AZ-GTi は対応してなさげですね。

Bluetooth SPP

では別な無線化の方法を提案してみます。まず AZ-GTi とは HAND CONTROLLER のポートを使ってシリアルで通信ができるのでこれを利用します。Bluetooth には SPP という Bluetooth を介してシリアル制御を行えるという通信規約があります。これをサポートするモジュールを HAND CONTROLLER ポートに接続することによって Bluetooth 経由でシリアル接続することができます。PC でこれらモジュールを Bluetooth デバイスとして追加してあげるとその後はあたかもシリアルポートが追加されたように見えます。Windows だと COMxx、macOS だと /dev/cu.xx のような感じで。

制作

それほどは難しくないです。Bluetooth SPP をサポートするモジュールを用意して、HAND CONTROLLER のポートにつなぐだけです。今回は手持ちの ATOM lite (M5Stack) を使いました。スイッチサイエンスさんなどで入手できます。便利につかうには電源を HAND CONTROLLER ポートからいただくので、三端子レギュレータ(またはDC-DCレギュレータ)も付けます。

部品

ATOM lite (スイッチサイエンス) ... 1,496yen

低損失三端子レギュレーター 5V 500mA (秋月電子) ... 100yen

もしくは BP5293-50 5V 2A (秋月電子)... 240yen こちらの方がおすすめ。

6極6芯モジュラージャック DIP 化キット(秋月電子) ... 100yen

基板(適当)(秋月電子) ... 40yen

ピンヘッダ 1x40 (秋月電子) ... 35yen

半田少々

線材少々

モジュラーコード 6極4芯 (絶対4芯あるのにしてください)

ファームウェア

ATOM lite のプログラムです。すっごく簡単です。RX を 19, TX を 22 ピンにアサインしました。AZ-GTi とのシリアル通信は 9600bps, 8bit, パリティなしです。また ATOM-SPP という名前のデバイスにしました。loop() の delayMicroseconds(105) は ATOM->AZ-GTi のデータ転送速度が間に合うよう 1/9600sec の wait を入れてます。もう少し短くしてもいいかもしれないけど。delay(1) だと 1ms で長すぎで、AZ-GTi からのデータが多いと取りこぼす可能性あるのかなと。

/*

*******************************************************************************

* Copyright (c) 2023 by Tatsuro Sato

*

* describe:ATOM SPP module

* date:2023/9/6

*******************************************************************************

*/

#include "M5Atom.h"

#include "BluetoothSerial.h"

#define RX_PORT 19

#define TX_PORT 22

#define AZ_GTI_SERIAL_SPEED 9600

BluetoothSerial SerialBT;

void setup() {

M5.begin(true, false, true);

Serial2.begin(AZ_GTI_SERIAL_SPEED, SERIAL_8N1, RX_PORT, TX_PORT);

SerialBT.begin("ATOM-SPP");

M5.dis.drawpix(0, 0x000099);

}

void loop() {

if (SerialBT.available()) {

Serial2.write(SerialBT.read());

}

if (Serial2.available()) {

SerialBT.write(Serial2.read());

}

delayMicroseconds(105);

}

回路図

- モジュラージャック 2 pin (TX) - ATOM lite G19 (RX)

- モジュラージャック 3 pin (Vpp+ 7.5~14V) - TA48M05F(BP5293-50) 1 pin (input)

- モジュラージャック 4 pin (RX) - ATOM lite G22 (TX)

- モジュラージャック 5 pin (GND) - TA48M05F(BP5293-50) 3 pin (GND) - ATOM lite GND

- TA48M05F(BP5203-50) 2 pin (5V out) - ATOM lite 5V

すいません、最初にアップした回路図の TA48M05F のピン番号 2 と 3 が逆でした。真ん中が 3 です。ちなみに TA48M05F は 12V->5V と結構電圧降下があるのでとても熱くなります。Rohm の BP5293-50 に変えてみたのですが、外付けのコンデンサは無くてよく、熱くもならないのでこちらの方がお勧めです。端子は同じなので置き換えるだけ。若干大きいのがいまいちですが。

使い方

- AZ-GTi に上記モジュールを接続し、電源を入れる

- PC で Bluetooth のデバイスの追加を行う

ATOM-SPP というデバイスが見つかるのでそれを追加する

macOS の場合、一旦接続になり数秒で切断されるが気にしない。

通信を再開させると自動的に接続される。 - PC のデバイス設定を確認する

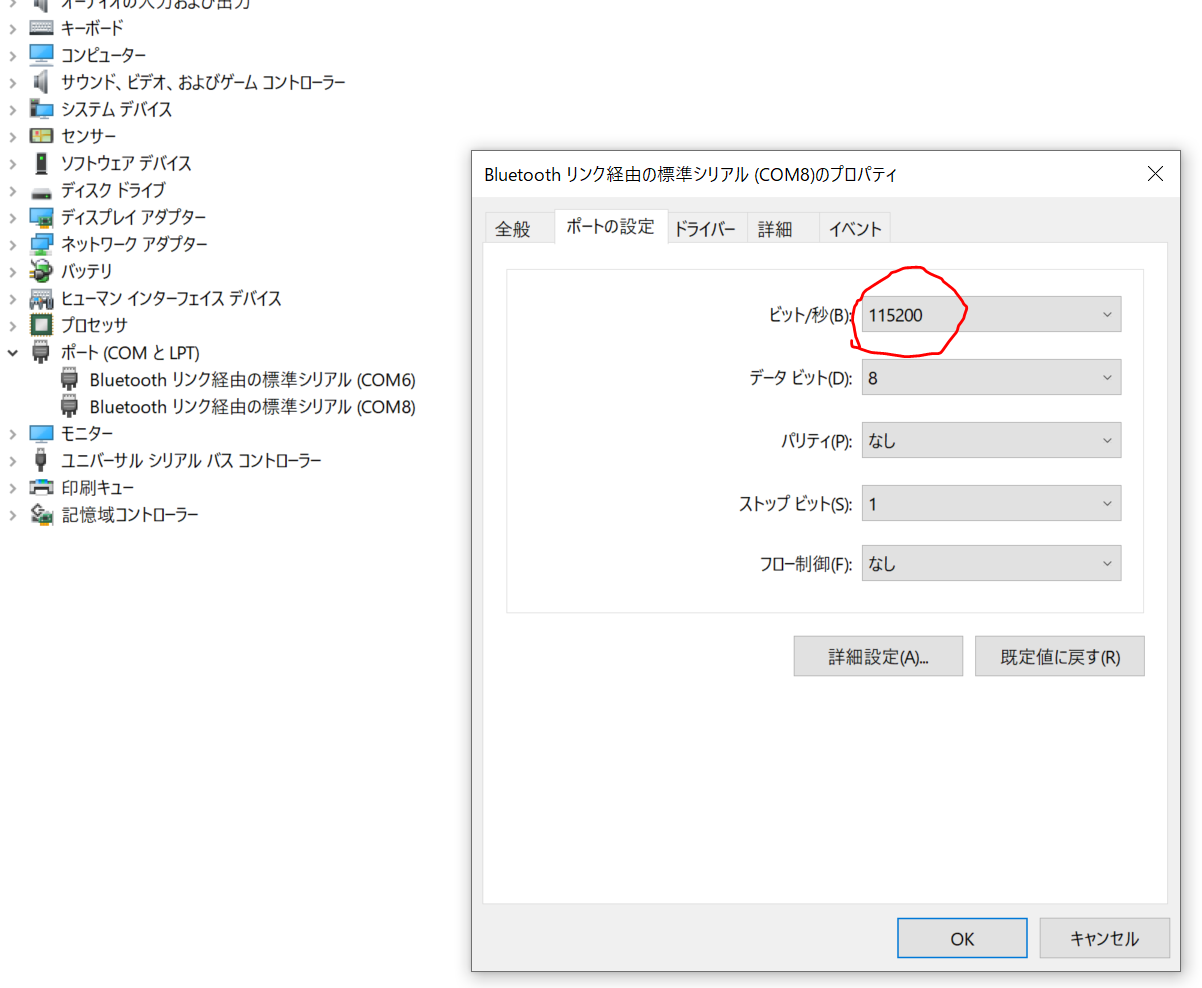

- Win

デバイスマネージャーのポート(COM と LPT)に Bluetooth リンク経由の標準シリアルが二つ追加されている。どっちが有効かわからないので両方ためしてみる。 - macOS

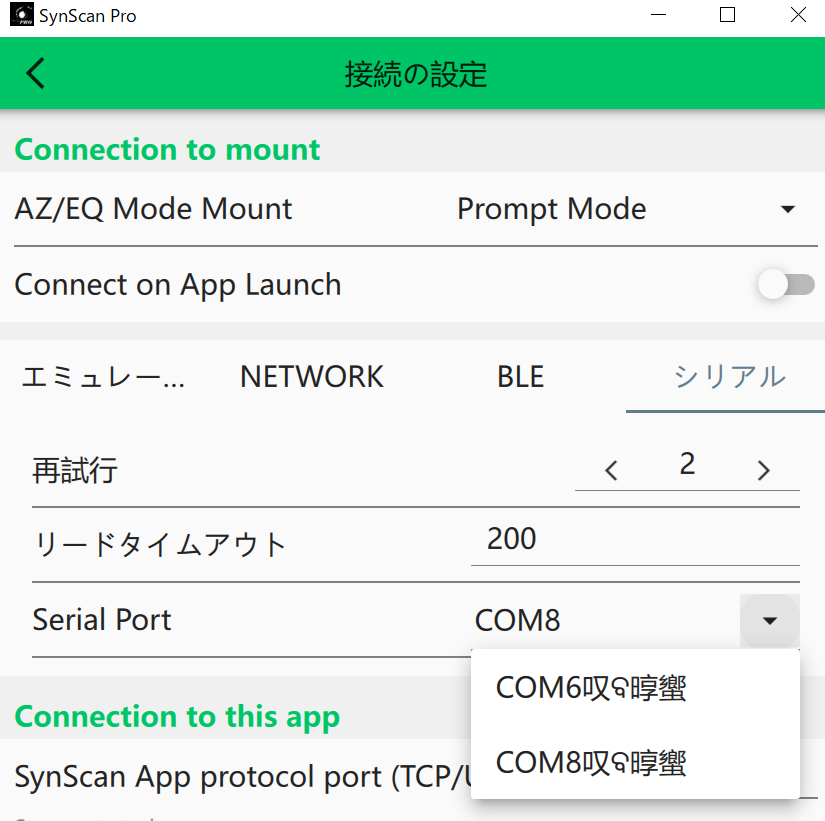

ターミナルソフトなどで ls /dev とやると、cu.ATOM-SPP というのがみつかるはずです。 - SynScan Pro を立ち上げ設定をする

設定→接続の設定→ Serial Port に設定します。 - Win

上記で調べた COMxx を選択します - macOS

/dev/cu.ATOM-SPP

を書き込みます - 接続

接続する

で接続できる。。と思います。

あれ?接続できない?不安定かも?と思ったら

デバイスマネージャーで、シリアルの通信速度確認してみてください。115200 にしてください。ほかの設定も合わせること。8ビット、パリティなし、ストップビット 1、フロー制御なし。

Windows の SynScan で、COM ポート名に文字化けした文字列がくっつくケースがあります。この部分を削除した値を設定してください。

2023/05/08

バドミントンのダブルスのペアの生成を ChatGPT で試してみる

はじめに

バドミントンなどでダブルスのペアを決める時にじゃんけんや組み合わせの乱数表などをつかったりするのですが、じゃんけんだと案外偏ってしまったり、乱数表だと疲れたり調子が悪くて予定外の人が休憩入れたりすると訳わからなくなってしまいます。

そんな時に役立つアプリ

を作ってみたのですが、こんな?アプリなんてなくても ChatGPT でできるんじゃ?というのが今回の試みです。

あ、無償、広告なし(今のところ)のこの太っ腹なアプリを使ってくれてもいいですよ。

ChatGPT でデータを処理させたり、プログラムコード生成をさせてみるというのはあるのだけど、落合陽一氏が ChatGPT でプロンプトを書くことをプログラミングするという言い方がちょっと面白いなと思って、なんか試してみようというのがモチベーション。よし、ChatGPT をプログラムを実行するプラットフォームとして見てみよう。

余談ですが昨今の AI による画像生成すごいですよね。リアルなものは本物にかなり近づいてきましたね。

目標

さて ChatGPT は無償で使える 3.5 を使ってみます。プログラムとなる ChatGPT への命令(プロンプト)を作り、追加条件のコート数、プレイヤー名を与え、組み合わせの生成をリクエストすると組み合わせを生成してくれる。ようなものをつくることを目標にします。

実験

ChatGPT へのプロンプトを作成する前に、条件(制約)を明確に決める必要があります。というか条件をうまく決めることがプログラミングということですね。プロンプトには色々スタイルがあるようですが、ChatGPT が理解しやすそうな自然言語(文章)ならなんでもいい(はず)です。

条件

とりあえずバドミントンのダブルスの条件を箇条書きで書いてみます。まずは一つのコートだけの条件を考えてみます。

- バドミントンのダブルスの試合は二組のペアで作られる。二組のペアが揃わない時は試合が組めない。

- ペアは二人の選手で構成される。選手が二人未満ではペアは作れない。

- 選手は同じ回で複数のペアに参加することはできない。

- 前回休憩した選手は優先的にペアを作る選手に選択される。ペアの組み合わせは前に組んでいない組み合わせを優先する。

- 以前組んだことがある場合、組んだ回数がすくないペアを優先する。

- ペアを組めない選手は休憩する。

とりあえずこれで試してみます。

あ、日本語よりは英語の方がより思った答えが出やすいので、上記条件を英訳してプロンプトにしてみます。Google 翻訳で訳したのが以下。

A badminton doubles match is made up of two pairs. You can't set up a match if you don't have two pairs.

A pair consists of two players. A pair cannot be formed with less than two players.

Players may not participate in more than one pair in the same inning.

Players who took a break last time will be selected as priority players for pairing. Priority is given to combinations that have not been paired before.

If the pair has been paired before, priority is given to the pair that has been paired with the least number of times.

Athletes who cannot form a pair rest.

これをプロンプトっぽく仕立てます。# で何の条件か指定して、あとは条件を箇条書きしています。

プロンプト

# Badminton doubles pair generation condition 1. The Badminton doubles match is made up of two pairs. 2. A match cannot be made with less than two pairs. 3. A pair consists of two players. 4. A pair cannot be made with less than two players. 5. Players must not participate in more than one pair in the same round. 6. Players who took a break last round will be selected as priority players for pairing. 7. Priority is given to combinations that have not been paired before. 8. If the pair has been paired before, priority is given to the pair that has been paired with the least number of times. 9. Players who cannot participate take a rest.

さてこれで試してみます。CharGPT にアクセスして、上記をそのままいれて送信するとなにやら ChatGPT が理解した内容を返してきます。

その後に、プレイヤーのリストと、10回分の組み合わせを生成するよう命令します。プレイヤーのリストは Player list という言葉とプレイヤーを「:」で区切ってみました。またプレイヤーの名前は敢えて日本語で、しかも区切りは「、」を使ってみました。結果を見るとちゃんと識別していますね。

また命令は日本語だと意図が正しく伝わらなかったことがあるので英語で書いてます。あれ、なんで猫入れちゃったんだろう。。

Player list: 犬、猫、猿、雉、桃太郎、鬼 Can you generate pairs for 10 rounds? け

結果

Sure! Based on the given player list and the conditions provided, the following pairs can be generated for 10 rounds: Round 1: - Pair 1: 犬 and 猫 - Pair 2: 猿 and 雉 Round 2: - Pair 1: 猫 and 雉 - Pair 2: 犬 and 桃太郎 Round 3: - Pair 1: 犬 and 猿 - Pair 2: 桃太郎 and 鬼 Round 4: - Pair 1: 猫 and 猿 - Pair 2: 雉 and 鬼 Round 5: - Pair 1: 犬 and 雉 - Pair 2: 猫 and 桃太郎 Round 6: - Pair 1: 犬 and 鬼 - Pair 2: 猿 and 桃太郎 Round 7: - Pair 1: 猫 and 桃太郎 - Pair 2: 猿 and 鬼 Round 8: - Pair 1: 犬 and 猿 - Pair 2: 雉 and 桃太郎 Round 9: - Pair 1: 犬 and 桃太郎 - Pair 2: 猫 and 鬼 Round 10: - Pair 1: 猿 and 雉 - Pair 2: 桃太郎 and 鬼 Note that in each round, priority was given to the players who took a break in the last round, and the pairs were selected based on the conditions provided. Also, after each pair was selected, the players in the pair were removed from the list of available players for the next round.

2023/02/05

MacBook Air M2 で Windows11 ARM 環境は使い物になるのか?

購入マシン構成とその経緯

速度と体感

速度

| Machine | CPU | OS | Single-core | Multi-core |

| MacBook Pro 2015 | Core-i7 | Monterey | 744 | 3294 |

| MacBook Air M2 | M2 | Ventura | 1909 | 8923 |

| Machine | VM | OS | Single-core | Multi-core |

| MacBook Pro 2015 | (Bootcamp) | Windows10 | 731 | 3173 |

| MacBook Air M2 | Parallels18 | Windows11 | 1662 | 5560 |

macOS だと Intel Mac (Monteley) のスコアが 744/3294 のところ、M2 Air (Ventrura) が 1909/8923 程度。Windows だと Bootcamp (Win10) が 731/3173 で、Parallels 仮想環境 (Win11) が 1662/5560 という結果になりました (それぞれ single core/multi core の値)。macOS 同士の比較で 2.6/2.7 倍で Windows 同士だと 2.27/1.75倍と仮想環境はやや遅めとはいえど、2倍程度の速度の違いがあり、十分体感できる差になります。あれ、こんなもんかとは思いましたが。ただしバッテリーの持ちは抜群で、丸一日使ってもまだ余裕ある感じです。倍の性能で何倍電池持つんだよって感じで。macOS の方も、積極的に輝度下げたりとか低消費電力対策をしてるようには感じましたが。

体感

Parallels vs UTM

Parallels Standard Edition vs Pro Edition

VM

Windows 11

Ubuntu

M2 Air で出来たこと出来ていないこと

天文関係

macOS

- Firecapture 2.7.10 + ASI462MC

- ASIStudio v1.7 + ASI462MC

- SynScan Pro v2.1.12 + AZ-GTi

Win11

- PiPP x64 v2.5.9

- Autostakkert 3.1.4

- RegiStax6 Version6.1.0.8

- WinJUPOS 12.2.4

組み込み系

macOS

- Arduino IDE + M5Stack Basic, Gray, Stick, Stick+, Atom-Matrix,Atom-Lite,M5 Core2,M5Paper,CoreInk

- MakeCode + micro:bit

Win11

- Gowin V1.9.8.09 Education + TangNano4K, TangNano9K

上手くできなかったもの ToDo

- SynScan Pro (望遠鏡の架台 AZ-GTi の制御)

Windows からだとツールは立ち上がります。シリアル接続がうまくいかないです。なぜかこの環境だとシリアルデータに偶数パリティが追加されるようで、それが原因のようです。Mac 版があることがわかってそれが動作するのでいいのですが、他のソフトとの連帯はどうなんだろ。 - SyarpCap

起動はします。カメラ認識してくれないんですよ。ZWO で ARM 向けのドライバを用意してくれていないからだと思います。ただ、ZWO としてはなんかしてくれそうな雰囲気。 - Vivado 2015 (旧Xilinx の FPGA 向けツール)

入れたけど起動せず。困ったことにアンインストールもできずに無駄なディスクを食ってます。OS 入れなおそうか。。新しいバージョンは動いているらしい事例ありです。 - Tang Dynasty (TangPrimer 搭載 Anlogic の FPGA 向けツール)

Win は Bitstream まで出せるが、ダウンロードできない, Ubuntu では起動しないが、シリアルは認識してるので、どっちもどっちな感じ。惜しい。Win 11 ARM 向けドライバ作ってー。もしくは Linux 版リビルドしてー。 - Quatus (旧Altera の FPGA 向けツール)

Win, Ubuntu ともにインストールすらままならず。Win 版 Quatus は WSL が必要らしいので、入れてみようと思ったけど WSL そのものが入らず。そもそも仮想マシンの仮想マシンってどうよという。しかも WSL で Ubuntu が走ったとしても ARM 系 Ubuntu だと結局だめじゃんとなりそう。

.png)